Penerapan

Data Mining Dalam Pengumpulan Data di Rumah Sakit

Tahapan - tahapan Knowledge Discovery in Database (KDD)

- KDD berhubungan dengan teknik integrasi dan penemuan ilmiah,

interprestasi dan visualisasi dari pola-pola sejumlah kumpulan data.

- Knowledge discovery in databases (KDD) adalah keseluruhan proses non-trivial untuk mencari dan mengidentifikasi pola (pattern) dalam data, dimana pola yang ditemukan bersifat sah, baru, dapat bermanfaat dan dapat dimengerti.

Tahapan Proses KDD

1. Data Selection

- Menciptakan himpunan data target , pemilihan himpunan data, atau

memfokuskan pada subset variabel atau sampel data, dimana penemuan

(discovery) akan dilakukan.

- Pemilihan (seleksi) data dari sekumpulan data operasional perlu

dilakukan sebelum tahap penggalian informasi dalam KDD dimulai. Data hasil

seleksi yang akan digunakan untuk proses data mining, disimpan dalam suatu

berkas, terpisah dari basis data operasional.

2. Pre-processing/ Cleaning

- Pemprosesan pendahuluan dan pembersihan data merupakan operasi

dasar seperti penghapusan noise dilakukan.

- Sebelum proses data mining dapat dilaksanakan, perlu dilakukan

proses cleaning pada data yang menjadi fokus KDD.

- Proses cleaning mencakup antara lain membuang duplikasi data,

memeriksa data yang inkonsisten, dan memperbaiki kesalahan pada data,

seperti kesalahan cetak (tipografi).

- Dilakukan proses enrichment, yaitu proses “memperkaya” data yang

sudah ada dengan data atau informasi lain yang relevan dan diperlukan

untuk KDD, seperti data atau informasi eksternal.

3. Transformation

- Pencarian fitur-fitur yang berguna untuk mempresentasikan data

bergantung kepada goal yang ingin dicapai.

- Merupakan proses transformasi pada data yang telah dipilih, sehingga

data tersebut sesuai untuk proses data mining. Proses ini merupakan proses

kreatif dan sangat tergantung pada jenis atau pola informasi yang akan

dicari dalam basis data

4. Data mining

- Pemilihan tugas data mining; pemilihan goal dari proses KDD misalnya

klasifikasi, regresi, clustering, dll.

- Pemilihan algoritma data mining untuk pencarian (searching)

- Proses Data mining yaitu proses mencari pola atau informasi menarik

dalam data terpilih dengan menggunakan teknik atau metode tertentu.

Teknik, metode, atau algoritma dalam data mining sangat bervariasi.

Pemilihan metode atau algoritma yang tepat sangat bergantung pada tujuan

dan proses KDD secara keseluruhan.

5. Interpretation/ Evaluation

- Penerjemahan pola-pola yang dihasilkan dari data mining.

- Pola informasi yang dihasilkan dari proses data mining perlu

ditampilkan dalam bentuk yang mudah mimengerti oleh pihak yang

berkepentingan.

- Tahap ini merupakan bagian dari proses KDD yang mencakup pemeriksaan

apakah pola atau informasi yang ditemukan bertentangan dengan fakta atau

hipotesa yang ada sebelumnya.

Macam -

Macam Algoritma Classification

Algoritma

Decision Tree

Decision

Tree (Pohon

Keputusan) merupakan teknik paling mudah untuk dipahami dalam mengklasifikasi

data.

Decision Tree memiliki:

Decision Tree memiliki:

1.

Akar dan

setiap node internalnya memiliki pertanyaan.

2.

Cabang

merepresentasikan setiap kemungkinan jawaban untuk dikaitkan dengan pertanyaan

3.

Setiap leaf

node merepresentasikan prediksi jawaban dari masalah

Leaf node

menunjukkan kelas untuk tuple yang sesuai. Tuple merupakan sekumpulan

urutan elemen yang nilainya bukan integer negatif.

Decision

Tree memiliki tiga bagian:

1.

Decision

Tree

2.

Algoritma

untuk membuat Decision Tree

3.

Algoritma

yang menerapkan tree menjadi data

Algoritma

Pohon Keputusan :

Input:

T = Decision Tree

D = Input Database

Output:

M =

Prediksi Model

Proses:

t = prediksi

arc = cabang

For each t element D do

n = root node of T;

while n not leaf node do

Dapatkan jawaban dari pertanyaan n lalu

taruh pada t;

If arc from t berisi jawaban benar

n = node berakhir pada cabang ini;

Buat prediksi ulang untuk t selanjutnya

berdasarkan label n terakhir;

Algoritma Naive Bayes

1. Konsep

Naive Bayes

Simple naive Bayesian classifiermerupakan salah satu metode

pengklasifikasi berpeluang sederhana yang berdasarkan pada

penerapan Teorema Bayes dengan asumsi antar variabel penjelas saling bebas

(independen).Algoritma ini memanfaatkan metode probabilitas dan statistik yang

dikemukakan oleh ilmuwan Inggris Thomas Bayes, yaitu memprediksi probabilitas

di masa depan berdasarkan pengalaman di masa sebelumnya. Dua kelompok peneliti,

satu oleh Pantel dan Lin, dan yang lain oleh Microsoft Research memperkenalkan

metode statistik Bayesian ini pada teknologi anti spam filter. Tetapi yang

membuat algoritma Bayesian filtering ini popular adalah pendekatan yang

dilakukan oleh Paul Graham. Dasar dari teorema naive digunakan

dalam pemrograman adalah rumus Bayes berikut ini:

P (A|B) =

(P(B|A) * P(A))/P(B)

Artinya

Peluang kejadian A sebagai B ditentukan dari peluang B saat A, peluang A, dan

peluang B.

2.

Penggunaan Naive Bayes

Contoh

penggunaan Algoritma Naive Bayes antara lain:

Untuk

klasifikasi Dokumen

Untuk deteksi

SPAM atau fitering SPAM Dan masalah klasifikasi lainnya

3. Algoritma Naive Bayes

Teorema

Bayes:

P(C|X) =

P(X|C)·P(C) / P(X)

Dimana :

P(X)

bernilai konstan utk semua klas

P(C)

merupakan frek relatif sample klas C

Dicari

P(C|X) bernilai maksimum, sama halnya dengan P(X|C)·P(C) juga bernilai maksimum

Masalah à

menghitung P(X|C) tidak mungkin

ü Apabila diberikan k atribut yang

saling bebas (independence), nilai probabilitas dapat diberikan sebagai

berikut.

P(x1,…,xk|C) = P(x1|C) x … x P(xk|C)

ü Jika atribut ke-i bersifat diskret,

maka P(xi|C) diestimasi sebagai frekwensi

relatif dari sampel yang memiliki nilai xi sebagai atribut ke i dalam

kelas C.

ü Namun jika atribut ke-i bersifat

kontinu, maka P(xi|C)

diestimasi dengan fungsi densitas Gauss.

|

1

|

x

|

2

|

||||||

|

f (x)

|

e

|

2 2

|

||||||

dengan

= mean, dan = deviasi standar.

Algoritma

Logistic Regression

Regresi

logistic merupakan salah satu analisi multivariate, yang berguna untuk

memprediksi dependent variabel berdasarkan variabel independen.

Data

Pada

logistic regresi, dependen variabel adalah variabel dikotomi (kategori). Ketika

kategori variabel dependennya berjumlah dua kategori maka digunakan binary

logistic, dan ketika dependen variabelnya lebih dari dua kategori maka

digunakan multinominal logistic regression. Lalu ketika dependen variabelnya

berbentuk ranking, maka disebut dengan ordinal logistic regression.

Konsep Regresi Logistik

Regresi

logistik merupakan alternative uji jika asumsi multivariate normal distribution

pada variabel bebasnya tidak bisa terpenuhi ketika akan dilakukan analisis

diskriminan. Tidak terpenuhinya asumsi ini dikarenakan variabel bebas merupakan

campuran antara variabel kontinyu (metric) dan kategorial (non metric).

Misalnya, probabilitas bahwa orang yang menderita serangan jantung pada waktu

tertentu dapat diprediksi dari informasi usia, kebiasaan merokok, jenis

kelamin, dan lainnya.

Asumsi Regresi Logistik

· Regresi logistik tidak

membutuhkan hubungan linier antara variabel bebas dengan

variabel terikat.

· Regresi logistik dapat

menyeleksi hubungan karena menggunakan pendekatan non

linier log transformasi untuk

memprediksi odds ratio. Odd dalam regresi logistik sering

dinyatakan sebagai

probabilitas. Misal Odd sebuah perusahaan dapat bangkrut atau

berhasil atau odd seorang

anak dapat lulus atau tidak pada Ujian Nasional.

· Variabel bebas tidak

memerlukan asumsi multivariate normality

· Asumsi homokedastis

tidak diperlukan

· Variabel bebas tidak

perlu dirubah ke bentuk metric (interval atau skala ratio)

Algoritma Support Vector Machine

Support

Vector Machine (SVM) adalah salah satu metode PR yang akhir-akhir ini banyak

mendapat perhatian. Support Vector Machine (SVM) dikembangkan oleh Boser,

Guyon, Vapnik, dan pertama kali dipresentasikan pada tahun 1992 di Annual

Workshop on Computational Learning Theory. Konsep dasar SVM sebenarnya

merupakan kombinasi harmonis dari teori teor ikomputasi yang telah ada puluhan

tahun sebelumnya, seperti margin hyperplane (Duda & Hart tahun 1973, Cover

tahun 1965, Vapnik 1964, dsb.), kernel diperkenalkan oleh Aronszajn tahun 1950,

dan demikian juga dengan konsep-konsep pendukung yang lain. Akan tetapi hingga

tahun 1992, belum pernah ada upaya merangkaikan komponen – komponen tersebut.

Prinsip dasar SVM adalah linear classifier, dan selanjutnya dikembangkan agar

dapat bekerja pada problem non-linear. dengan memasukkan konsep kernel trick

pada ruang kerja berdimensi tinggi.

(SVM ) juga

dikenal sebagai teknik pembelajaranmesin (machine learning) paling mutakhir

setelah pembelajaran mesin sebelumnya yang dikenal sebagai Neural

Network ( NN). Baik SVM maupun NN tersebut telah berhasil digunakan dalam

pengenalan pola. Pembelajaran dilakukan dengan menggunakan pasangan data input

dan data output berupa sasaran yang diinginkan. Pembelajaran dengan cara ini

disebut dengan pembelajaran terarah (supervised learning). Dengan pembelajaran

terarah ini akan diperoleh fungsi yang menggambarkan bentuk ketergantungan

input dan outputnya. Selanjutnya, diharapkan fungsi yang diperoleh

mempunyai kemampuan generalisasi yang baik, dalam arti bahwa fungsi tersebut

dapat digunakan untuk data input di luar data pembelajaran.

Konsep SVM

dapat dijelaskan secara sederhana sebagai usaha mencari hyperplane terbaik yang

berfungsi sebagai pemisah dua buah class pada input space. Gambar 1a

memperlihatkan beberapa pattern yang merupakan anggota dari dua buah class :

positif (dinotasikan dengan +1) dan negatif (dinotasikan dengan –1). Pattern

yang tergabung pada class negatif disimbolkan dengan kotak, sedangkan pattern

pada class positif, disimbolkan dengan lingkaran. Proses pembelajaran dalam

problem klasifikasi diterjemahkan sebagai upaya menemukan garis (hyperplane)

yang memisahkan antara kedua kelompok tersebut.

Berbagai

alternatif garis pemisah (discrimination boundaries) ditunjukkan pada Gambar

1a. Hyperplane pemisah terbaik antara kedua class dapat ditemukan dengan

mengukur margin hyperplane tsb. dan mencari titik maksimalnya. Margin adalah

jarak antara hyperplane tersebut dengan data terdekat dari masing-masing class.

Subset data training set yang paling dekat ini disebut sebagai support vector

Garis solid pada Gambar 1b menunjukkan hyperplane yang terbaik, yaitu yang

terletak tepat pada tengah-tengah kedua class, sedangkan titik kotak dan

lingkaran yang berada dalam lingkaran hitam adalah support vector. Upaya

mencari lokasi hyperplane optimal ini merupakan inti dari proses pembelajaran

pada SVMD data yang tersedia dinotasikan sebagai sedangkan label masing-masing

dinotasikan untuk i= 1,2,…,l, yang mana l adalah banyaknya data.

Diasumsikan kedua class – 1 dan +1 dapat terpisah secara sempurna oleh

hyperplane berdimensi d, yang didefinisikan: Sebuah pattern yang termasuk class

–1 (sampel negatif) dapat dirumuskan sebagai pattern yang memenuhi

pertidaksamaan: sedangkan pattern yang termasuk class +1 (sampel positif):

CONTOH KASUS

Sebuah rumah sakit ingin ingin

menekan biaya perawatan pasien tanpa mengurangi kualitas pelayanan.

Salahsatu potensi yang dapat dimanfaatkan pada penerapan data mining di

rumah sakit adalah mengidentifikasi atribut-atribut penentu biaya pasien rawat

inap. Dengan mengetahui atribut penentu biaya rawat, diharapkan pihak manajemen

rumah sakit dapat melakukan kontrol terhadap biaya, sehingga ongkos perawatan

pasien dapat ditekan tanpa mengurangi kualitas pelayanan.

Untuk mengidentifikasi atribut penentu

biaya pasien rawat inap, digunakan data kunjungan pasien rawat inap RSUP Dr.

Cipto Mangunkusumo dengan jaminan Jamkesmas periode 1 Januari 2009 s/d 30

September 2010 daridatabase SIMRS sebanyak 2022 kunjungan (jumlah sebelum

dilakukan data cleaning 8383). Dengan teknik analisa Atttibute

Importance (AI) didapatkan atribut-atribut penentu biaya dengan urutan sebagai

berikut: prosedur medis 1 (AI=0,16), prosedur medis 4 (AI=0,15), prosedur medis

3 (AI=0,14), LOS (AI=0,13), prosedur medis 2 (AI=0,13), organisasi (AI=0.10),

diagnosa utama (AI=0,08), jenis kelamin (AI=0.02) dan status kawin (AI=0.01).

Hasil klasifikasi dengan teknik Algoritma Naive Bayes menunjukkan model yang

dibuat memiliki predictive confidence sebesar 50,41%.

Data

Untuk mengidentifikasi atribut-atribut penentu biaya

pasien rawat inap, digunakan data kunjungan pasien rawat inap RSUP Dr. Cipto

Mangunkusumo dengan jaminan Jamkesmas periode 1 Januari 2009 s/d 30 September

2010 yang diambil dari database SIMRS sebanyak 8383 kunjungan

pasien. Setelah dilakukan data cleaning, didapatkan 2022 kunjungan

pasien yang layak untuk dianalisa.

Perangkat Lunak

Untuk analisa data mining digunakan

perangkat lunak Oracle Data Miner dan database Oracle 11g.

Metode & Teknik

Atribute Importance (AI)

Attribute Importance (AI) memberi peringkat atribut

dengan menghilangkan atribut yang berulang, tidak relevan, atau tidak

informatif dan mengidentifikasi atribut yang mungkin memiliki pengaruh yang

paling tinggi dalam

membuat prediksi.

AI menggunakan algoritma Minimum Description Length (MDL). Algoritma MDL

mempertimbangkan setiap atribut sebagai model prediktif sederhana dari kelas

target. Teknik AI digunakan untuk mengoptimalkan analisa model classification

dengan mengurangi atribut yang digunakan dan akan meningkatkan kecepatan dan

akurasi saat membangun model.

Data Scoring

Setelah model dibuat dengan aplikasi data

mining, model tersebut bisa digunakan untuk membuat prediksi dari data baru

yang dalam hal ini diterapkan untuk memprediksi pola biaya data kunjungan

pasien. Model biasanya dibuat dengan menggunakan data historis dari kunjungan

pasien sebelumnya.

Prosesnya dapat digambarkan sebagai berikut:

Teknik Data Mining

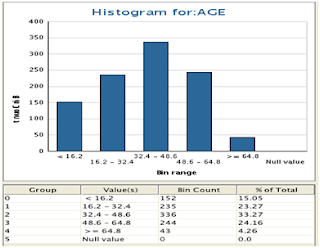

4.1 Persiapan Data

Sebelum

dilakukan teknik data mining dilakukan eksplorasi data untuk

mengetahui distribusi data pasien berdasarkan atribut tertentu (misal:

distribusi pasien berdasar umur) dan juga untuk mengidentifikasi data yang

tidak normal (outliers). Data divisualisasikan dalam bentuk histogram. Beberapa

histogram profil kunjungan pasien ditampilkan sebagai berikut :

Distribusi

berdasarkan Gender

Distribusi

berdasarkan Umur

Distribusi

berdasarkan Unit Kunjungan

Keterangan Gambar :

178 = A - Penyakit Dalam

105 = A - Onkologi Obgin

108 = A –

Bedah 121 = Kebidanan

(IGD)

173 = A - Bedah LT 4

113 = A - Obgin

176 = A - Mata

175 = A - THT

109 = A – Neurologi 101 = PJT - Intermediate Ward Lt. 4

Distribusi

berdasarkan Status Kematian

Distribusi

berdasartkan Length of Stay

Dalam studi ini data kunjungan pasien di RSCM

akan diamati atribut-atribut yang akan mempengaruhi pola biaya pasien yang

dirawat di RSCM. Untuk biaya di buat skala RENDAH, SEDANG dan TINGGI. Dengan

aturan sebagai berikut :

Jika Biaya Tagihan < 10 juta Maka Pola

biaya RENDAH.

Jika Biaya Tagihan >10 juta dan < 50

juta maka biaya SEDANG.

Sedangkan jika Biaya tagihan > 10 juta

maka pola biaya TINGGI.

Permasalahan pada data yang memiliki banyak

atribut seperti data rekam medis pasien adalah tidak semua data akan

berkontribusi jika diterapkan model prediktif, bahkan beberapa atribut

cenderung mengaburkan hasil (noise). Teknik Attribute Importance (AI) digunakan

untuk mengidentifikasi indikator yang paling berpengaruh terhadap pasien dengan

pola biaya tinggi atau rendah. Setelah dianalisa menggunakan teknik Attribute

Importance (AI), data akan dianalisa menggunakan teknik klasifikasi menggunakan

Algoritma Naïve Bayes yang kemudian akan digunakan untuk melakukan scoring

terhadap kasus kunjungan pasien.

Sumber : http://www.sigitprabowo.id/2013/04/data-mining-tahap-tahapan-knowladge.html

http://fazri-indop.blogspot.co.id/2012/03/contoh-kasus-data-mining.html

http://fazri-indop.blogspot.co.id/2012/03/contoh-kasus-data-mining.html

Tidak ada komentar:

Posting Komentar